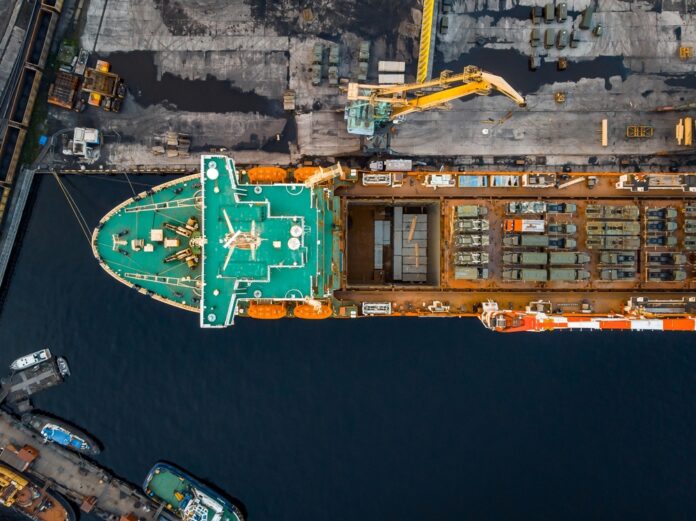

Il dirigente della Regione Sicilia Giancarlo Teresi è stato arrestato con l’accusa di corruzione aggravata per aver favorito Cosa nostra. Secondo l’inchiesta, avrebbe assegnato lavori pubblici alla società riconducibile al boss di Favara Carmelo Vetro in cambio di tangenti. Entrambi sono finiti in carcere. Coinvolti nell’indagine anche Salvatore Vetro, fratello del capomafia, e Antonio Lombardo, amministratore formale dell’azienda. Per gli investigatori Teresi avrebbe messo per anni la propria funzione al servizio degli interessi del boss, già condannato per mafia, ricevendo diversi pagamenti illeciti. Sotto esame appalti per bonifiche, dragaggi e ripascimenti nei porti di Marinella di Selinunte, Scicli-Donnalucata e Terrasini.

La prima vittoria della Gen Z: in Nepal cambia il governo dopo 18 anni

Il vento delle proteste ha sortito i suoi effetti sulla rappresentanza politica istituzionale. Giovedì 5 marzo in Nepal si sono tenute le attese elezioni parlamentari per rinnovare la Camera Bassa del Paese, e, nonostante non sia ancora giunto a termine lo spoglio, il trentacinquenne Balen Shah sembra aver avuto la meglio contro il rivale e presidente uscente Sharma Oli. Questa tornata elettorale è stata la prima occasione per la popolazione nepalese di esprimere il proprio voto dopo le rivolte che, nel settembre del 2025, costrinsero il governo alle dimissioni. Balen Shah, ex rapper e già sindaco della capitale Kathmandu, che si era schierato coi manifestanti denunciando la corruzione del Paese.

Dopo la decisione del governo di bloccare temporaneamente l’accesso a più di venti social network, le fasce più povere della popolazione e una gran parte della cosiddetta “Generazione Z” sono insorte, organizzando attraverso la piattaforma online Discord le prime proteste. Il blocco dei social è stato la goccia che ha fatto traboccare il vaso: il tasso di disoccupazione giovanile al 21% e l’indice di povertà assoluta al 20% hanno infatti alimentato un malcontento esploso contro gli agi, spesso ostentati sugli stessi social, delle famiglie al potere. Durante le rivolte i manifestanti hanno preso d’assalto il Parlamento, la Corte Suprema e le residenze del presidente e hanno subito una violenta repressione che ha portato a più di settanta morti. Dopo le dimissioni di Sharma Oli, il testimone è passato nella mani della giurista Sushila Karki che ha indetto le elezioni per il marzo del 2026.

Tra i volti noti che hanno appoggiato con vigore le proteste spiccava Balen Shah (noto semplicemente come Balen), ingegnere di formazione, rapper di successo e sindaco di Kathmandu. Balen, che in occasione delle rivolte si è schierato dalla parte dei manifestanti, è stato visto come il successore più papabile per il ruolo di presidente del Paese e i risultati ai seggi sembrano confermare questa tendenza.

Volto nuovo della politica nepalese, Shah ha deciso di mettersi in gioco nel 2022 e ha riscontrato fin da subito un ottimo successo elettorale, che lo ha portato con il 39% delle preferenze a ricoprire il ruolo di sindaco della capitale. Durante il suo mandato, Shah ha messo a punto una serie di misure finalizzate ad un miglioramento drastico del sistema di raccolta dei rifiuti e alla lotta contro l’abusivismo edilizio. Seppure nel corso degli anni da sindaco alcune delle sue politiche siano state fortemente criticate, specialmente dagli abitanti delle baraccopoli da lui smantellate, la sua immagine pubblica ha visto un aumento della popolarità, anche grazie alla cura spasmodica delle sue reti social.

La tornata elettorale degli scorsi giorni ha visto quindi la messa in scena dello scontro dicotomico tra due concetti diversi di politica: da un lato il vecchio, rappresentato da Sharma Oli, che trae con sé gli ultimi vent’anni del potere nepalese. Settantaquattrenne e in lizza per un ipotetico quarto mandato, Oli è il presidente del Partito Comunista marxista-leninista unificato del Nepal e rappresenta l’immagine della corruzione istituzionale del paese. Rappresentante di un blocco che era al potere praticamente senza soluzione di continuità dalla fine della monarchia in Nepal, nel 2008. Dall’altro lato, invece, Balen incarna il nuovo e sembra aver raccolto il gravoso compito di portare una ventata di freschezza all’interno della scena politica. Nonostante ciò, è bene sottolineare che all’interno del Partito Rastriya Swatantra (Partito Nazionale Indipendente), la formazione politica con la quale ha deciso di correre alle presidenziali, non sono nuovi casi di illecito. Difatti, Rabi Lamichhane, fondatore del PRS, conduttore televisivo ed ex ministro degli Interni durante il governo Oli, è stato coinvolto in svariati scandali giudiziari, con accuse di istigazione al suicidio, frode e appropriazioni indebite.

Nonostante ciò, Balen Shah sembra essere riuscito a ottenere la fiducia dell’elettorato, grazie anche ad un abile posizionamento sulle manifestazioni dello scorso autunno e ad un programma elettorale incentrato sull’accesso a sanità e istruzione per le classi più povere. Secondo le ultime stime (aggiornate alle ore 17.30 GMT+5.45), il PRS è riuscito ad accaparrarsi 125 dei 165 seggi della Camera bassa determinati dal voto diretto. Mentre per quanto riguarda la rappresentazione proporzionale il Partito Nazionale Indipendente ha ottenuto 58 dei 110 seggi totali.

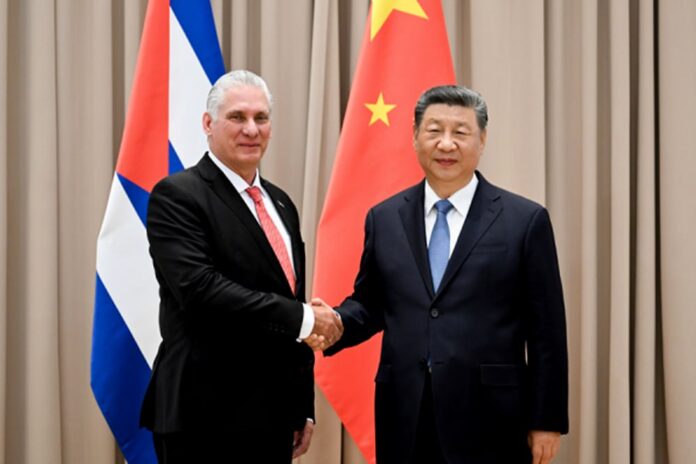

Nonostante lo scrutinio non sia ancora giunto al termine, il presidente uscente Sharma Oli ha già riconosciuto la vittoria del rivale, augurandogli attraverso un post su X un mandato quinquennale «sereno e proficuo». Sulla scena internazionale, invece, non si sono fatte attendere le congratulazioni del presidente indiano Narendra Modi, che ha reiterato «il suo impegno a lavorare a stretto contatto con il popolo del Nepal e il suo nuovo governo». Non è un caso che Modi abbia scelto di spendere delle parole per la probabile vittoria di Balen; difatti, il premier uscente Oli ha mantenuto nel corso degli anni relazioni cospicue con il principale rivale dell’India, la Repubblica Popolare Cinese, in particolar modo appoggiando gli interessi cinesi nell’ambito della Belt and Road Initiative.

Se i seggi confermeranno la probabile vittoria del giovane volto della politica nepalese Balen Shah, si potrà affermare che le ormai note “rivolte della Generazione Z” hanno ottenuto un primo reale successo elettorale. Chissà se il premier spinto dal vento della protesta riuscirà a soddisfare le aspettative.

Le esportazioni italiane di armi sono cresciute del 157% in cinque anni

«I flussi globali di armi aumentano di quasi il 10% mentre la domanda europea aumenta vertiginosamente». Così l’Istituto Internazionale di Ricerche sulla Pace di Stoccolma (SIPRI), uno dei più grandi istituti di studi sulla pace al mondo, titola il proprio comunicato in cui lancia il suo ultimo rapporto sull’esportazione delle armi. Mentre il mercato delle armi prolifera a livello globale, sono quelle italiane, in particolare, a registrare una decisa impennata, aumentando del 157% e facendo schizzare il Belpaese alla sesta posizione nella classifica globale delle nazioni esportatrici di armi.

In generale, nel mondo, le esportazioni di armi sono cresciute del 9,2% complessivamente nel 2021-2025 rispetto al quinquennio precedente (2016-2020). Non tutte le aree del globo hanno tuttavia collaborato a tale aumento: se a trainare il trendi vi sono gli Stati delle Americhe (+12%) e dell’Europa (i quali hanno triplicato le vendite negli ultimi cinque anni, registrando un +210%), calano l’export degli altri continenti – Asia, Oceania e Africa – e dell’area del Medio Oriente. Nel periodo 2021-2025, in particolare, gli USA hanno esportato il 74% del totale delle armi: dei 99 Stati che le hanno acquistate, la maggior parte (35) si trova in Europa. Si tratta della prima volta in vent’anni, riporta SIPRI, che questo accade. L’Europa, insomma, aumenta le proprie esportazioni, ma in buona parte si tratta di armi acquistate dagli USA – le cui esportazioni verso il nostro continente sono triplicate negli ultimi cinque anni. Per quanto riguarda i soli 29 Paesi NATO in Europa, oltre la metà delle armi importate provengono dagli USA (il 58% del totale).

Dal canto suo, i 27 Stati UE hanno rappresentato il 28% dell’export globale negli ultimi cinque anni – quattro volte quello della Russia e cinque volte quello della Cina. E tra i principali esportatori al mondo in questo periodo vi è proprio l’Italia, che si colloca ora al sesto posto della classifica globale (classifica nella quale la Francia è al secondo posto, la Germania al quarto e la Spagna al decimo). Nel quinquenni 2021-25, l’export di armi in Italia è cresciuto del 157% rispetto al periodo precedente, facendo sì che ora le armi da noi esportate siano il 5,1% del totale globale. Queste vengono inviate per la maggior parte in Medio Oriente (59%), ma anche verso l’Asia e l’Oceania (16%) e l’Europa (13%).

Come sottolinea la Rete Pace e Disarmo, il dato italiano smonta definitivamente la narrazione del governo per svuotare la legge 185/90, secondo la quale le imprese italiane sarebbero svantaggiate dalla concorrenza europea a causa di controlli più severi. Una narrazione che è definitivamente smontata dai dati: “non c’è alcuno svantaggio competitivo da attribuire ai controlli della legge 185/90” sottolinea la Rete, che rilancia la campagna Basta Favori ai Mercanti delle Armi. Quest’ultima chiede di non modificare la normativa, oltre a maggior trasparenza su contratti e destinazioni e lo stop al riarmo.

Golfo di Napoli, scossa di magnitudo 5.9

Pochi minuti dopo la mezzanotte si è registrata nel Golfo di Napoli, nei pressi di Capri, una scossa di magnitudo 5.9, a 414km di profondità. «Il terremoto è stato avvertito in tutta Italia», scrive l’Istituto nazionale di geofisica e vulcanologia (INGV), aggiungendo che: «in questi casi fortunatamente la grande profondità determina una forte attenuazione delle onde sismiche e quindi un minore impatto sul territorio». Al momento non si registrano infatti feriti o danni infrastrutturali.

Bollette, gas e benzina: i costi della guerra all’Iran si riversano sugli italiani

Il recente scoppio del conflitto in Medio Oriente ha causato una nuova scossa sui mercati energetici globali, con effetti immediati sui prezzi di petrolio e gas, anche nel nostro Paese. Il greggio Wti ha sfondato quota 93 dollari al barile, registrando un +36% in sette giorni, uno strappo che non si vedeva dal 1983. Gli effetti sui consumatori italiani sono già palpabili, con la benzina self service schizzata ai massimi dal luglio dello scorso anno e il gasolio self service che ha addirittura raggiunto i picchi di ottobre 2023, con punte superiori ai 2,5 euro al litro in autostrada. Secondo le prime stime da parte delle associazioni di rappresentanza, nel nostro Paese un nucleo familiare potrebbe dover affrontare quasi mille euro aggiuntivi all’anno tra bollette, benzina e acquisti al supermercato.

A destare il massimo allarme è, in particolare, la tenuta degli approvvigionamenti. Il blocco dello Stretto di Hormuz, attraverso cui transita un quinto del petrolio mondiale e un terzo del commercio globale di materie prime per fertilizzanti, rischia infatti di provocare un taglio del 15-20% all’offerta di greggio. Il Qatar ha già paventato lo stop all’esportazione di gas naturale liquefatto, di cui è fornitore chiave per i paesi europei e asiatici. «Magari quella sul gasolio fosse una speculazione – commenta Davide Tabarelli di Nomisma Energia –. Questa è una crisi devastante e ci aspetta anche di peggio. Manca il 20% del petrolio mondiale. Manca anche il gas, perché passa dallo Stretto di Hormuz. La situazione è complicatissima».

Rispetto all’impatto di luce e gas, è intervenuta una nota dell’Ufficio studi della CGIA di Mestre, che ha stimato in circa 10 miliardi l’incremento dei costi energetici che, nel 2026, potrebbe gravare sulle imprese del nostro Paese. Nello specifico, si parla di 7,2 miliardi per l’elettricità e 2,6 per il gas, con un +13,5% rispetto al 2025. Le quotazioni, che alla vigilia dell’attacco vedeva il gas a 32 euro al megawattora e l’elettricità a 107,5, sono balzate rispettivamente a 55,2 e 165,7 euro in pochi giorni. Secondo le proiezioni, le regioni che subirebbero maggiormente l’impatto sarebbero Lombardia, Emilia-Romagna e Veneto – ovvero le “locomotive” del Nord. Tra i settori più in pericolo figurano, secondo l’analisi, la metallurgia, il commercio, l’alimentare, gli alberghi, il trasporto e logistica e la chimica per l’elettricità, oltre all’estrattivo, la lavorazione alimentare, il tessile e la cantieristica navale per il gas. CGIA evidenzia la necessità di interventi immediati: a livello nazionale bonus sociali e taglio dell’Iva, sul versante comunitario il disaccoppiamento tra prezzo del gas e dell’elettricità.

A sottolineare le pesanti ricadute della situazione in Medio-Oriente sull’Italia è anche il Codacons, secondo cui anche solo l’aumento dell’inflazione di un punto percentuale si potrebbe trasformare in circa mille euro annui in più a famiglia tra bollette, carburanti, beni di consumo e mutui. A febbraio l’Istat aveva certificato un’inflazione all’1,6%, ma i dati non incorporavano ancora gli effetti del conflitto. I listini alla pompa intanto corrono: da venerdì scorso la benzina self è aumentata di 9,2 centesimi, il gasolio di 18,9. Le compagnie aeree, che devono fronteggiare deviazioni e cancellazioni, scaricheranno i maggiori costi sui biglietti. Secondo Confesercenti, nel frattempo, il turismo rischia di perdere nei prossimi mesi un miliardo di euro di spesa straniera. Altro comparto in allarme è l’export agroalimentare. Michele Ponso, presidente della Federazione nazionale di prodotto Frutticoltura di Confagricoltura, ha segnalato che «ci sono già navi cariche di mele ferme e sono arrivate numerose disdette di ordini per le prossime settimane». L’Arabia Saudita costituisce infatti il terzo mercato di riferimento per le mele italiane, registrando affari per circa 70 milioni di euro.

Le opposizioni vanno all’attacco del governo, sostenendo che il decreto Bollette da poco varato dall’esecutivo – che, tra misure tampone, coperture creative e riforme dalla dubbia efficacia, già appariva lontano dal rappresentare la soluzione strutturale auspicata – sarebbe già fortemente inadeguato di fronte alla nuova emergenza. «Continuiamo a dialogare con tutti i Paesi della regione e ad assistere i nostri connazionali ancora presenti nell’area, ma siamo anche al lavoro per mitigare il più possibile le conseguenze del conflitto per i cittadini, per la nostra Nazione, con task force attivate per monitorare l’andamento dei prezzi dell’energia, della benzina, dei generi alimentari e per combattere la speculazione – ha dichiarato ieri in un videomessaggio la premier Giorgia Meloni -. In particolare sulla benzina stiamo valutando anche di attivare il meccanismo delle cosiddette “accise mobili” che questo Governo ha reso più efficace con il provvedimento sui carburanti del 2023, nel caso in cui i prezzi aumentassero in modo stabile». Si attendono novità dal consiglio dei ministri previsto per martedì.

Nigeria, scontri tra miliziani ed esercito: 15 morti

Miliziani afferenti ai gruppi di Boko Haram – affiliato ad Al Qaeda – e dello Stato Islamico della Provincia dell’Africa Occidentale (ISWAP) – affiliato all’ISIS – hanno lanciato diversi attacchi negli Stati nigeriani del Borno e dello Yobe, uccidendo almeno 15 persone. Tra i morti, 12 soldati e tre civili. Gli attacchi hanno preso di mira una base militare nel distretto Kukawa, una nel distretto di Goniri e una a Dalwa; incendiate inoltre abitazioni e veicoli militari. Secondo fonti militari, gli attacchi sarebbero stati coordinati.

Kenya, alluvioni a Nairobi: 43 morti, l’allerta ignorata e il governatore sotto accusa

In poche ore Nairobi si è trasformata in una città sommersa dall’acqua a causa delle forti piogge: auto trascinate via dalla corrente, strade collassate, quartieri isolati e un bilancio di vittime che continua a salire. Ma dietro le alluvioni che hanno colpito la capitale e il Paese più in generale da venerdì scorso, non c’è soltanto la violenza della pioggia: c’è anche la storia di una metropoli fragile, avvertita in anticipo dal servizio meteorologico eppure rimasta esposta, ancora una volta, al disastro.

Il bilancio delle vittime delle inondazioni di venerdì sera è salito a 43 e in almeno 16 contee le famiglie stanno contando le perdite dopo che le inondazioni hanno spazzato via case, fattorie e strade, lasciando molte persone sfollate.

A Nairobi le acque hanno travolto oltre 170 veicoli, colpito infrastrutture e mandato in crisi la mobilità della capitale; in diversi quartieri si sono registrati blackout e disagi ai servizi. Nel quartiere di Hazina, nel Sud-Ovest di Nairobi, Citizen digital riporta che centinaia di residenti sono rimasti senza casa dopo che inondazioni improvvise hanno travolto il quartiere, distruggendo case e spazzando via proprietà. Una situazione simile è stata segnalata a Kinoo, dove alcune famiglie non hanno potuto accedere alle loro case rimaste sommerse. I residenti hanno affermato che almeno cinque chiese e diverse scuole sono state colpite.

«Ogni anno abbiamo un problema perenne di inondazioni. Oggi alcuni non possono nemmeno pregare. Molte famiglie sono intrappolate nelle loro case», ha riferito un cittadino alla testata, facendo trasparire la rabbia degli abitanti per i mancati interventi. Dopo un silenzio di 48 ore il governatore di Nairobi Johnson Sakaja, intervistato da Citizen Tv, ha tentato con difficoltà di scaricare le proprie responsabilità, dopo che i keniani l’hanno accusato di aver ignorato la priorità data all’installazione di canali di drenaggio efficienti. «Non mi dimetto. Lavoro e ogni giorno faccio del mio meglio, visti i limiti che abbiamo come città. Certo, le aspettative sono estremamente alte e le capisco, ma mi impegno davvero per risolvere i problemi con ciò che ho», ha detto, annunciando compensazioni per chi ha perso tutto e sottolineando che la situazione non può essere risolta con una soluzione rapida e che il sistema di drenaggio della città non è progettato per gestire l’intensità delle precipitazioni attuali.

Il Dipartimento meteorologico del Kenya aveva emesso un’allerta il 3 marzo 2026, valida fino al 9 marzo alle 19:00, avvertendo di precipitazioni superiori a 20 mm in 24 ore in gran parte del Paese, Nairobi compresa, con picco previsto tra il 4 e il 7 marzo e rischio esplicito di alluvioni.

Nicolò Govoni, fondatore di Still I Rise che è proprio a Nairobi per seguire le attività della scuola fondata qui, che dal 2024 è riconosciuta come International Baccalaureate (IB) world school, risponde al telefono mentre il cielo è tornato sereno e spende il sole.

«La città è assolutamente impreparata alla stagione delle piogge, che da aprile a giugno sono quotidiane. Capita spesso che piova fortissimo per qualche ora, con delle vere e proprie bombe d’acqua che travolgono tutto, per poi vedere tornare il sole, come accade ora», racconta a L’Indipendente. I cittadini sono disperati, vivendo in attesa della prossima tragedia. «Nel 2024 le forti piogge [nella foto di copertina, NdA] avevano causato 300 morti in tutto il Paese, con alluvioni devastanti. Cinque persone erano morte qui nel quartiere dove sorge la scuola e moltissime persone avevano perso la casa, in molti casi baracche costruite lungo l’argine del fiume, che scorre vicinissimo alla scuola e che sto guardando proprio mentre ti parlo».

La risposta di due ani fa del governo era stata quella di demolire tutte le baracche e le costruzioni abusive situate entro 30 metri dalle rive del fiume. Posto che molte di quelle case nel tempo sono state ricostruite, manca una visione a lungo termine per scongiurare le prossime emergenze. «Bisogna costruire gli argini del fiume che scorre in piena città, ripristinando dei canali di drenaggio efficienti», spiega, per evitare che le persone muoiano «o perché la baracca viene travolta dalla furia dell’acqua, o perché rimangono bloccati in auto e sommersi. Sono morti terribili».

Venerdì sera Nicolò era con 30 studenti in centro città a vedere una mostra su Pinocchio organizzata dall’ambasciata italiana. Sarebbero dovuti rientrare alle 18, ma sono rimasti bloccati dal diluvio. «Io stesso ho perso casa quella notte, che è all’interno della scuola. Avevo da qualche settimana delle infiltrazioni, e quella mattina l’impresa edile è venuta e ha tolto il tetto di lamiera per aggiustare le infiltrazioni, lasciandola così, senza metterla in sicurezza. Quindi ha piovuto per ore e il controsoffitto di gesso è crollato in tutta la casa. Sembrava di essere in un film apocalittico, tutto distrutto. Certamente non paragonabile rispetto a chi ha perso la vita, ma serve per far capire la situazione. Poi un conto è l’errore di un’impresa, un altro quello di un governo che non fa gli scarichi, nonostante i soldi ci siano».

Ora tutti sono in balia degli eventi. «Sicuramente verrà fatta qualche azione eclatante: come il rifare una singola strada con tutti i crismi costruttivi, per tranquillizzare il popolo inferocito, e poi basta. Ma gli interventi dovrebbero essere strutturali».

Nel frattempo il presidente William Ruto ha ordinato il dispiegamento di una risposta multi-agenzia, il rilascio di aiuti alimentari dalle riserve strategiche e la copertura delle cure per i feriti nelle strutture pubbliche. Misure necessarie nell’emergenza, ma che difficilmente basteranno a risolvere il problema più grande: una città che, ad ogni stagione delle piogge, torna a scoprire quanto sia fragile.

Quando il processo decisionale viene demandato alle intelligenze artificiali

L’avvento delle intelligenze artificiali è stato accompagnato dalla promessa di mantenere l’essere umano “in the loop”, ovvero di assicurarsi che ogni decisione finale restasse nelle mani di un dirigente in carne e ossa. Ma, pur continuando a ripetere questo principio, si moltiplicano gli indizi di un cambiamento profondo: il processo amministrativo sta scivolando sempre più verso una dipendenza strutturale dai chatbot. Una nuova ricerca britannica evidenzia infatti che la maggior parte dei dirigenti si trovi ormai nelle condizioni di assumere decisioni importanti solo dopo aver consultato un’IA.

Il dato arriva da Quick Thinking 2.0, un report che sintetizza i risultati di un sondaggio commissionato nel Regno Unito da Confluent, azienda attiva nel cloud e nell’analisi dei dati. Considerando il tipo di servizi offerti dalla società, non stupisce che il documento adotti un tono marcatamente propositivo, invitando le imprese ad abbracciare l’innovazione per non restare indietro. Ciò non toglie che le cifre riportate siano interessanti: offrono infatti uno spaccato significativo degli atteggiamenti manageriali emersi tra i 200 “business leader” coinvolti.

Tra i partecipanti al sondaggio emerge che il 62% ricorre ai chatbot ogni volta che deve compiere scelte manageriali significative. Nel 27% dei casi, queste riguardano assunzioni o licenziamenti. Inoltre, il 46% dei dirigenti interpellati ammette di affidarsi più ai suggerimenti dell’intelligenza artificiale che alle opinioni dei propri colleghi. Un quadro che solleva più di una perplessità, soprattutto considerando che i chatbot possono generare informazioni errate – “allucinare” – con una frequenza stimata tra il 3% e il 27%.

La crescente propensione ad affidarsi alle intelligenze artificiali viene spiegata dal fatto che l’82% dei leader aziendali intervistati dichiara di trovarsi spesso costretto a scegliere tra agire rapidamente o prendersi il tempo necessario per maturare decisioni più ponderate. Il 92% sostiene inoltre che, negli ultimi tre anni, il ritmo imprenditoriale sia aumentato in modo significativo, rendendo più urgente che mai dimostrare prontezza manageriale. Non sorprende quindi che il 60% lamenti di avere sempre meno tempo per prendere decisioni cruciali per il raggiungimento degli obiettivi di business.

In questo scenario, i chatbot vengono percepiti come un ponte di connessione tra i due estremi: strumenti capaci di sintetizzare in pochi istanti una mole di informazioni che, impiegando i metodi tradizionali, richiederebbe molto più tempo per essere analizzata. Le IA finiscono così per essere impiegate non piú come assistenti, ma come consulenti, soprattutto in situazioni che richiedono scelte critiche e tempi stretti – un contesto che rende ancora più difficile controllare l’affidabilità delle informazioni generate dai modelli.

Quanto riportato da Confluent offre uno spaccato del settore privato britannico che si basa su di un campione tutto sommato ristretto, non è detto che possa essere esteso automaticamente ad altri contesti. Tuttavia, queste statistiche restituiscono una misura concreta di un fenomeno che sta già incidendo su molti ambiti in cui figure apicali sono retribuite per farsi carico delle decisioni – talvolta anche difficili. Un assunto che, come dimostrano segnali sempre più frequenti, non riguarda soltanto il mondo aziendale ma tocca anche il perimetro dell’amministrazione pubblica.

Sappiamo, per esempio, che i recenti attacchi statunitensi e israeliani contro l’Iran sono stati supportati in qualche misura da sistemi di intelligenza artificiale. Sappiamo inoltre che il Department of Government Efficiency – guidato ufficiosamente da Elon Musk – ha delegato a ChatGPT la selezione di alcune realtà a cui tagliare i fondi, ritenute colpevoli di aver approfittato delle politiche di inclusività ed eguaglianza. I tagli sono stati eseguiti, salvo poi scoprire che in molti casi le valutazioni automatizzate erano errate e la supervisione umana é stata annullata in favore di una maggiore “efficienza”. Nel contesto militare, dove la trasparenza è ancora più limitata, è difficile ottenere dati affidabili sul tasso di errore: ciò che possiamo ipotizzare, però, è che le IA impiegate in ambito bellico non siano magicamente esenti da fallimenti e che, durante le operazioni più recenti, gli Stati Uniti hanno colpito anche delle scuole.